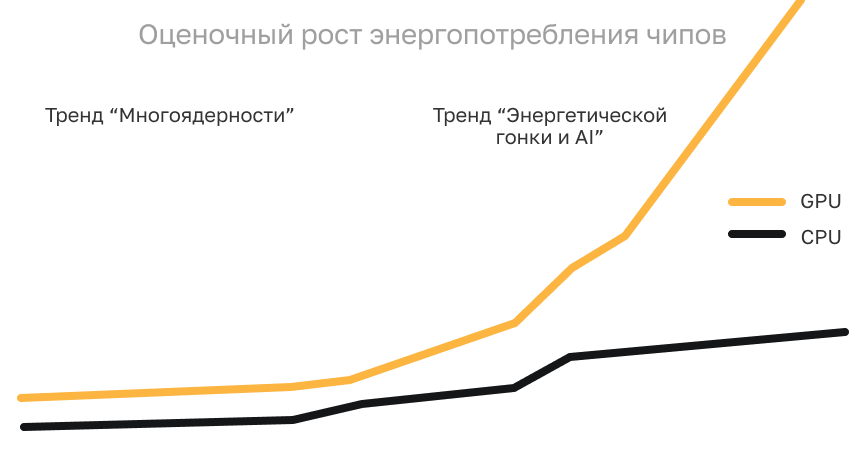

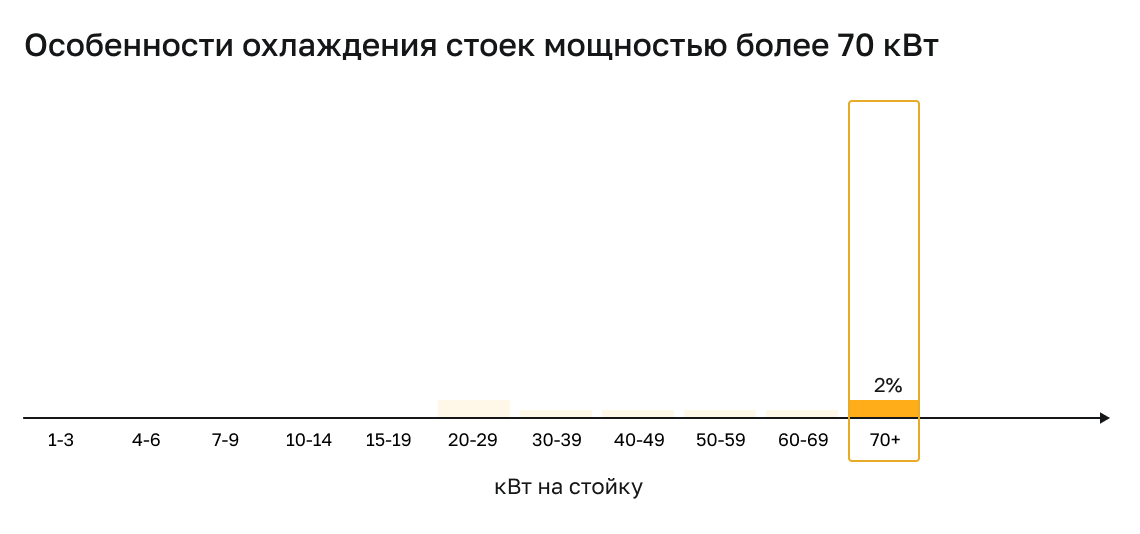

Плотность серверных стоек растет, тепловыделение процессоров ускоряет этот рост, а требования к охлаждению выходят далеко за рамки классического воздуха. Новые GPU легко выходят за предел 1000 Вт на чип, а CPU уверенно движутся к 500 Вт и выше. Одновременно снижается TCASE — верхний предел температуры корпуса. В таких условиях уже недостаточно «выбрать сервер и поставить в стойку», тип охлаждения напрямую влияет на стабильность всей инфраструктуры.

Инженерам важно понимать границы возможностей каждой технологии — от воздуха до DLC (Direct Liquid Cooling — прямое жидкостное охлаждение). В статье на практике ITGLOBAL.COM (корпорация ITG) разберем, где жидкостное охлаждение действительно необходимо, а где его применение бесполезно.

Почему «один вариант охлаждения» больше не работает

В последние годы рост TDP (Thermal Design Power — расчетная тепловая мощность) стал нормой. Производители процессоров начали стремиться к двум целям одновременно: повышать производительность и упаковывать всё больше вычислительных модулей в компактные сокеты. Итог предсказуем — тепловыделение увеличивается, а допустимая рабочая температура снижается.

Однако у воздуха есть фундаментальное ограничение — когда чипы под постоянной высокой нагрузкой, он перестает эффективно отводить тепло. Инженеры ITGLOBAL.COM делятся, что одни и те же серверы в зависимости от конфигурации могут работать стабильно, а могут троттлить уже при стандартной температуре машинного зала. Этой неопределенности и пытаемся избежать, инженерам приходится планировать систему охлаждения на этапе выбора сервера, а не после его установки.

Подходы к охлаждению: от воздушного до прямого жидкостного

Воздушное охлаждение — пределы применимости

В типичном ЦОД воздушная архитектура (фальшпол, периметральные кондиционеры, рядные установки) дает реальный потолок в:

8–10 кВт тепла на стойку.

В классическом ЦОД воздушная архитектура держит примерно 8–10 кВт тепла на стойку. Даже если подвести больше электричества, отвести дополнительное тепло становится трудно, ведь поток воздуха растет медленно.

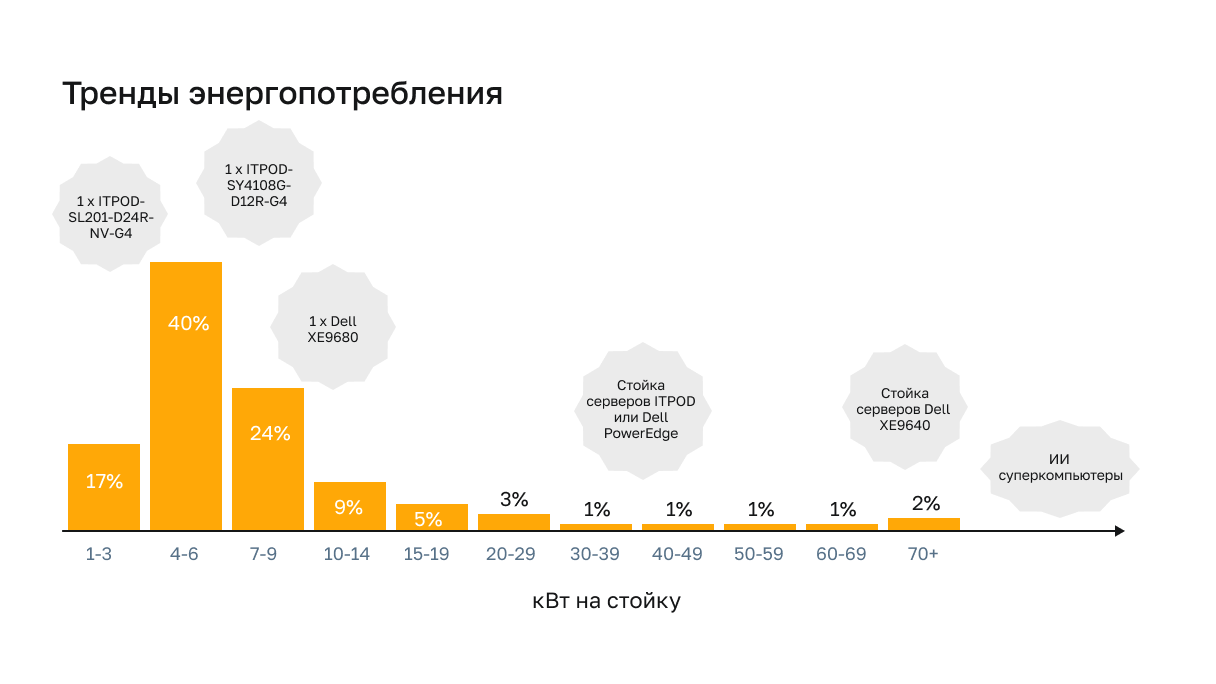

В пример специалисты приводят типовую стойку на 42U и серверы ITPOD-SL201-D24R-NV-G4. Теоретически туда можно поставить двадцать одну 2U-машину, но со средним энергопотреблением одного сервера — около 500 Вт — получаем 10–11 кВт на стойку. На деле система охлаждения вытягивает стабильно не более 8 кВт в большинстве коммерческих ЦОД, а выше приходится снижать плотность или вводить локальные кондиционеры между рядами.

Важным при воздушном охлаждении является влажностной режим, по стандартам в холодном коридоре необходимо поддерживать уровень влажности в диапазоне 40-60%, увеличивать сильнее влажность нельзя, может начать появляться конденсат.

Серьезный дата-центр уровня TierIII оснащается увлажнителями воздуха, персонал следит за этим параметром. В небольших серверных часто отсутствуют увлажнители и могут начаться проблемы с охлаждением. При падении влажности в холодном коридоре снижается теплоемкость воздуха, сухой воздух не может отвести требуемое количества тепла от высоконагруженных серверов, несмотря на достаточную производительность системы кондиционирования.

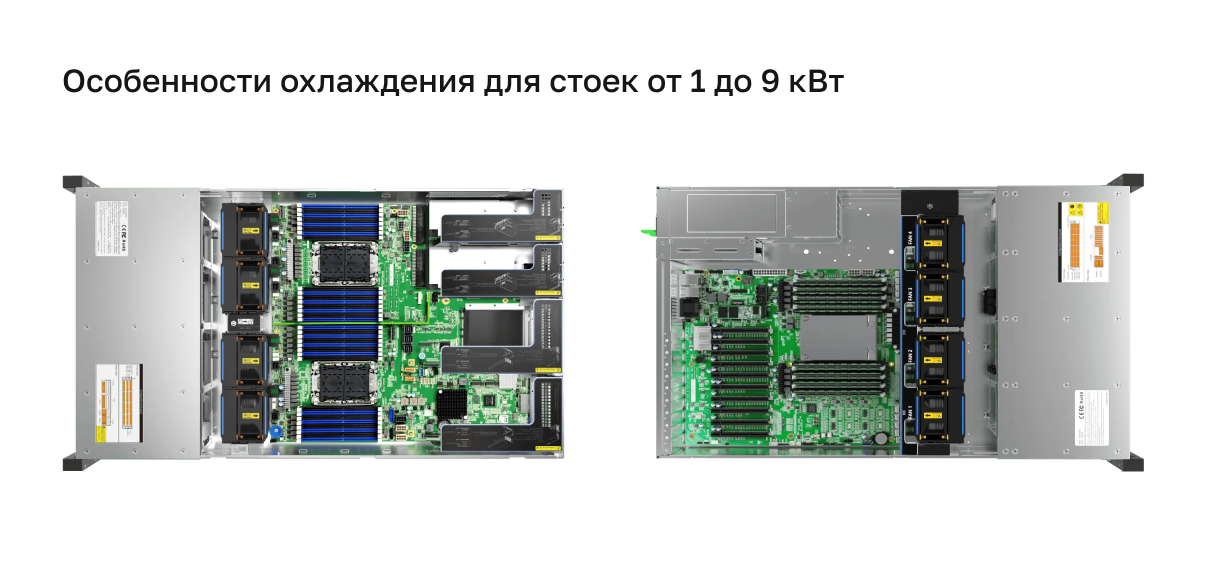

Типовое оборудование в диапазоне от 1 до 9 кВт, серии ITPOD General Computing и Network Appliance

В проектах ITGLOBAL.COM специалисты рекомендуют начинать с аудита существующей инфраструктуры, чтобы избежать недозагрузки стоек и оптимизировать выбор шасси под воздушное охлаждение.

Отсюда два рабочих вывода:

- «холод» заканчивается раньше, чем юниты;

- 2U-шасси рациональнее 1U — больше радиатор, выше производительность кулеров, меньше рисков троттлинга.

Поэтому в диапазоне до 10 кВт нет смысла переходить на жидкость: воздух справляется, если грамотно подобрать шасси и обеспечить корректный температурно-влажностный режим, особенно зимой.

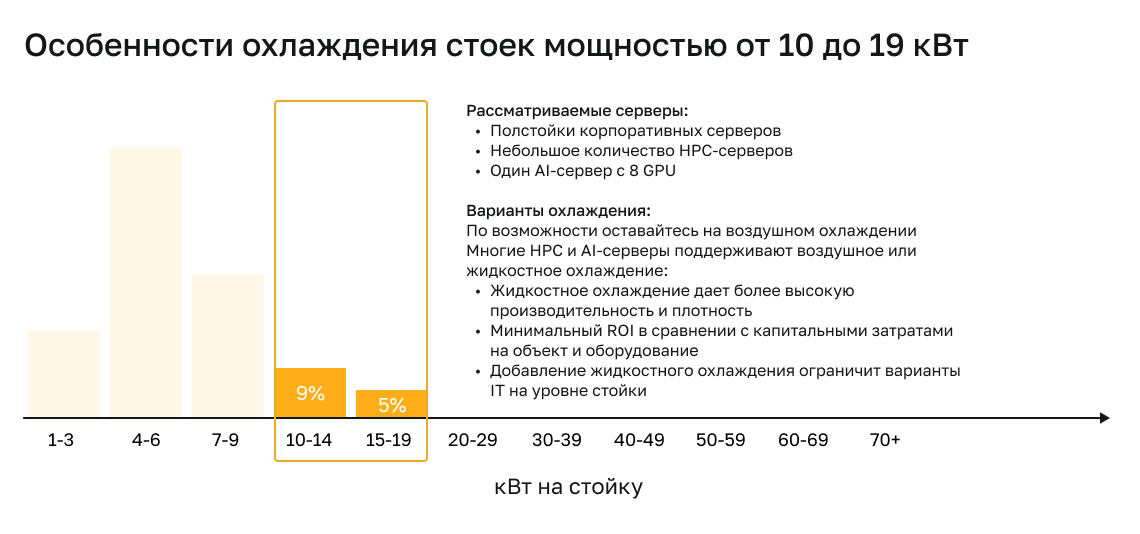

Диапазон 10–19 кВт: усиленное воздушное охлаждение и Liquid-to-Air

На уровне 10–19 кВт воздушное охлаждение еще работает, но уже требуется: увеличенный объем шасси, более крупные радиаторы и большее количество вентиляторов с повышенными оборотами. Жидкость здесь пока не обязательна, но становится вопросом эффективности и акустики.

В этом диапазоне появляются первые «тяжелые» конфигурации:

- 8U серверы формата HGX с 8× GPU (например, Dell XE9680);

- 4U варианты с восемью картами класса NVIDIA RTX PRO 5000 Blackwell (например, ITPOD-SY4108G-D12R-G4).

Поэтому инженеры постепенно смотрят в сторону Liquid-to-Air и начинают вводить локальные элементы жидкостной схемы без полного перехода на DLC.

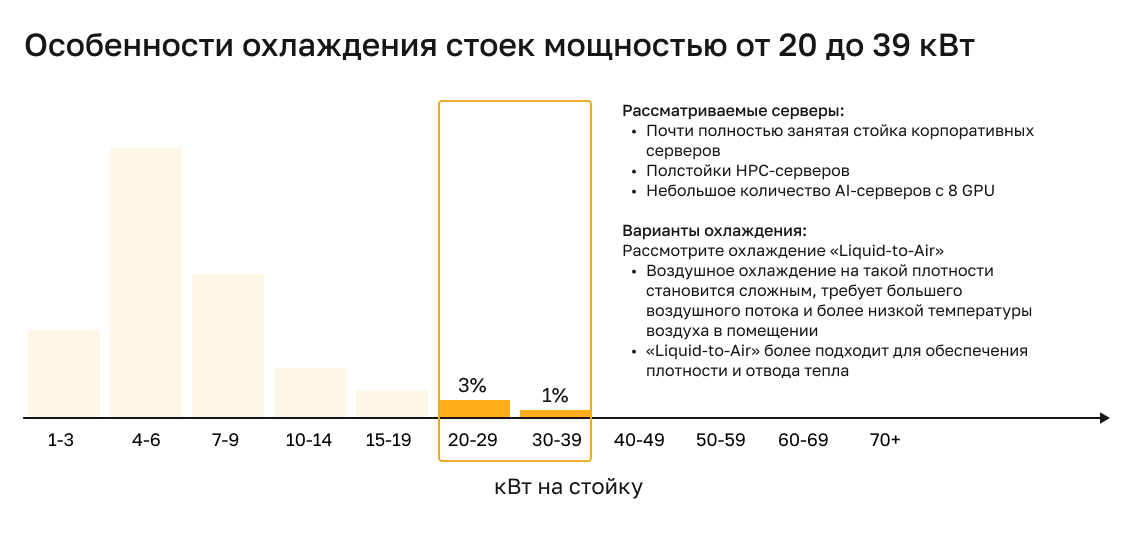

Диапазон 20–39 кВт: Liquid-to-Air и RDHX

Когда плотность стойки подходит к 20–39 кВт, температуру в зале приходится снижать, стойку — надо заполнять, а шум и вибрации вентиляторов растут быстрее, чем тепловой эффект.

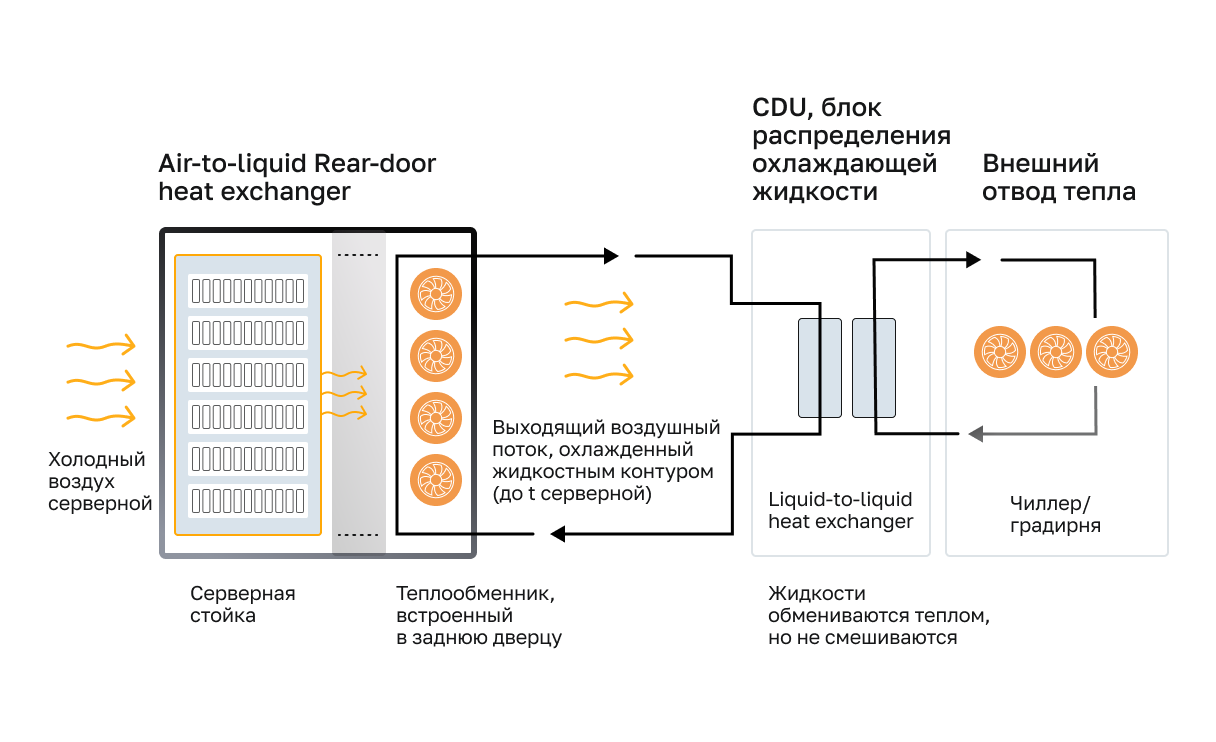

В этот момент появляется RDHX (Rear Door Heat Exchanger) — теплообменник задней двери — самый мягкий и гибкий вход в жидкостное охлаждение ЦОД. По сути, это «узаконивание» охлаждения там, где оно действительно работает: в непосредственной близости к серверам. Вода заходит в теплообменник, снимает лишнее тепло и уходит обратно в систему. В итоге не нужно перестраивать весь ЦОД, достаточно задуматься о градирне, а плотность можно поднимать почти без ограничений.

Важно, что RDHX не привязан к конкретной конфигурации и рядом с ним могут стоять ИИ-серверы, СХД и сетевое оборудование — теплообменник обслужит все единообразно. Также среди преимуществ:

- тепло снимается у самого источника тепла;

- падают потери на транспортировку воздуха;

- повышается плотность без глобальной перестройки инфраструктуры;

- можно смешивать разное оборудование в одной стойке — ИИ-сервера, СХД, сетевое.

Для решения небольших задач можно использовать компактные Liquid-to-Air CDU внутри стойки — решения от VENTTECH или Soeteck Power. Это также шаг между чистым воздухом и прям

жидкостным охлаждением.

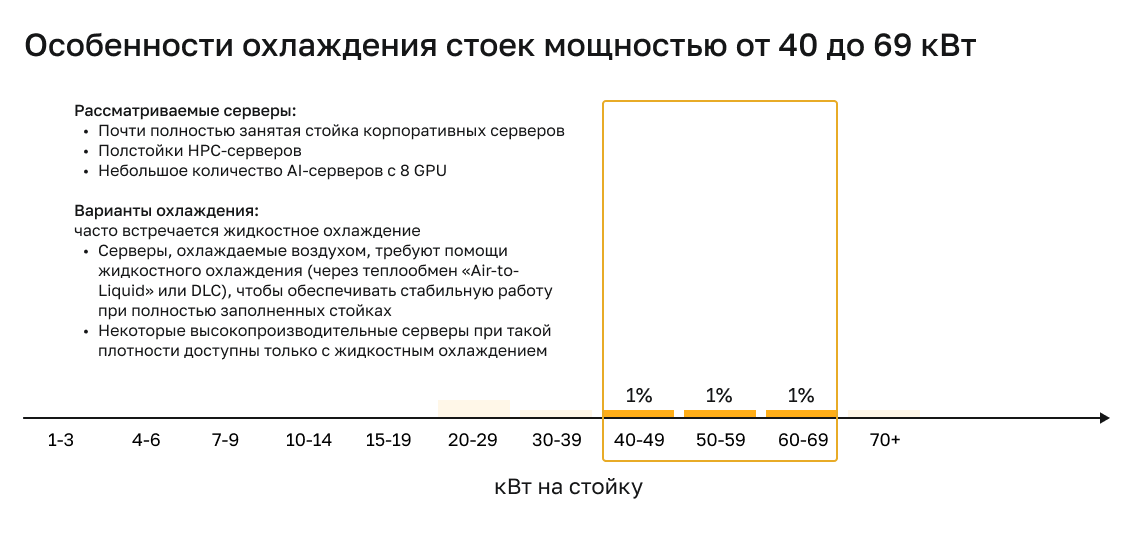

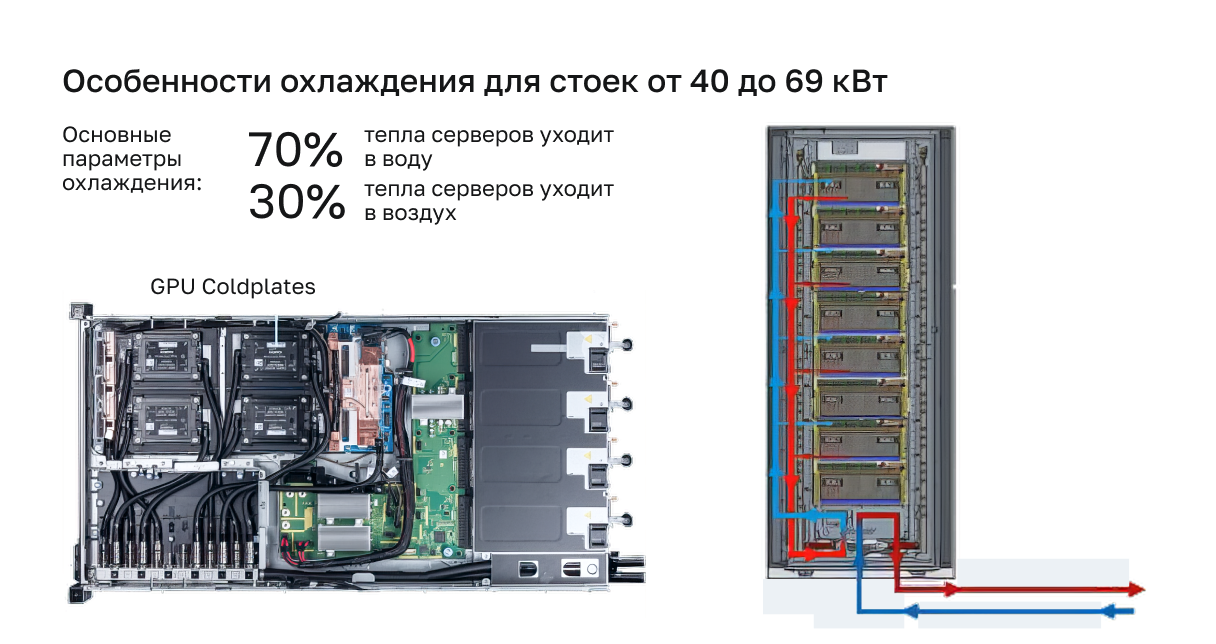

40+ кВт: зона прямого жидкостного охлаждения (DLC)

При 40–70 кВт выбор уже невелик. Воздушное охлаждение можно усиливать сколько угодно, но физика побеждает инженерию и холодные пластины становятся единственным стабильным вариантом.

Например, стойка с восемью серверами Dell XE9640 на базе HGX — это сразу 60–69 кВт. В таких конфигурациях в ITGLOBAL.COM к Liquid-to-Liquid:

- в сервере алюминиевые радиаторы заменяются медными пластинами;

- жидкость проходит через них, забирает тепло и возвращается в CDU;

- CDU, в свою очередь, передает его в Facility Water — первичный контур здания.

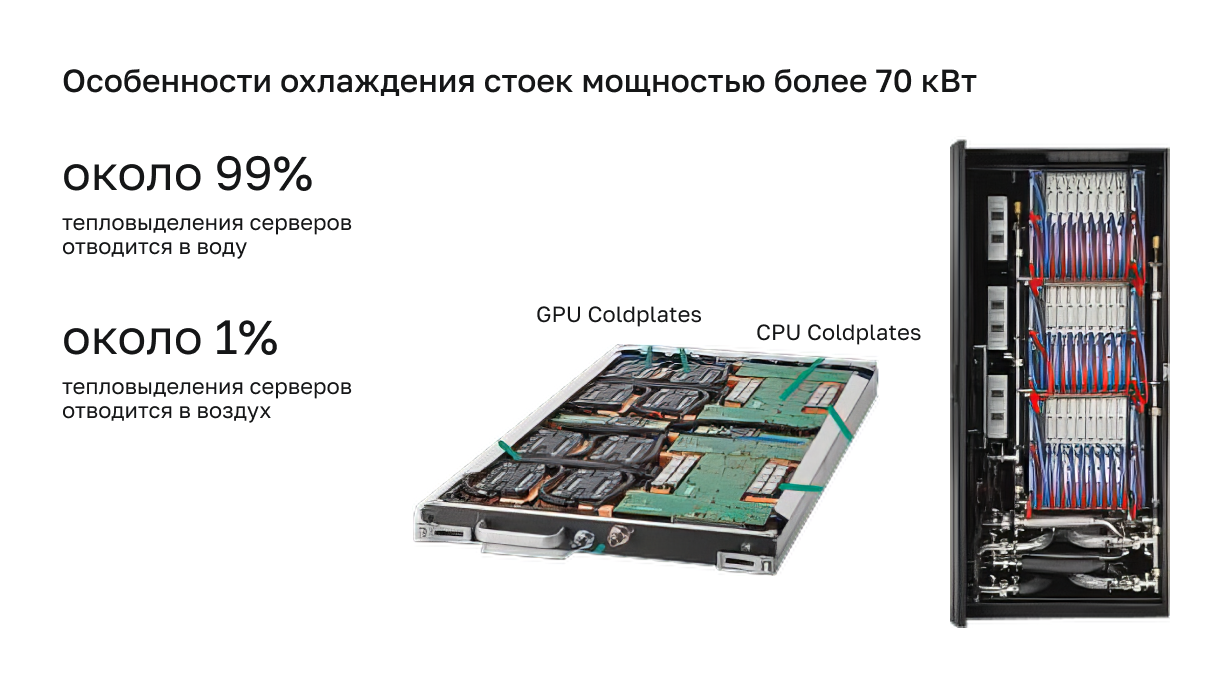

Без прямого жидкостного охлаждения (Direct Liquid Cooling, DLC) стойка просто не выдержит нагрузки. Оно работает по принципу «охлаждаем только самое горячее»: GPU, CPU, NVLink Switch и иногда — память.

Диски, сетевые карты, интерфейсные адаптеры — все это остается на воздухе. У них меньше тепловыделение, и нет необходимости усложнять контур там, где прирост эффективности минимален.

CDU: сердце двухконтурной системы жидкостного охлаждения

Системы при CDU строятся на двух водяных контурах:

- Первый контур (Facility Water) обеспечивает ЦОД. Это большая система на уровне здания: насосы, трубы, резервуары, градирни или чиллера. Вода — очищенная, иногда с ингибиторами, чтобы остановить коррозию и рост биопленок.

- Второй контур — внутри стоек и серверов — работает смеси воды и PGW или EG в пропорциях до 25–40%, потому что такие смеси устойчивы к коррозии, биопленкам и низким температурам.

CDU стоит между ними и играет роль границы, одновременно сохраняя необходимую температуру и давление.

Размещается он по разному. Как отдельно стоящая (централизованная) CDU охлаждает сразу группу стоек, но все они должны быть однородными по нагрузке. Из плюсов такого вида — можно подготовить инженерную инфраструктуру ЦОД заранее.

Есть и другой вариант — CDU на уровне стойки (4U). В этом случае каждая стойка автономна и проста в обслуживании. Этот вариант позволяет смешивать разные типы оборудования с разными тепловыми профилями

Стандартизация фитингов и соединений

На фоне развития технологий охлаждения, теперь возникает вопрос о про совместимости между производителями. За последние годы индустрия почти полностью стандартизировалась. Большинство CDU и серверов используют санитарные фланцы и триклампы из нержавеющей стали — те же, что ставят в пищевой промышленности. Это обеспечивает полную совместимость оборудования от разных производителей — критично в гибридных кластерах.

«Если вы были в нашей пивоварне ItColon — соединения покажутся знакомыми».

Василий Белов, исполнительный директор ITGLOBAL.COM

Стойки 100 кВт: новая реальность ИИ

Если несколько лет назад стойка на 100 кВт звучала как эксперимент HPC-класса, то сегодня это обычный сценарий для ИИ-кластеров.

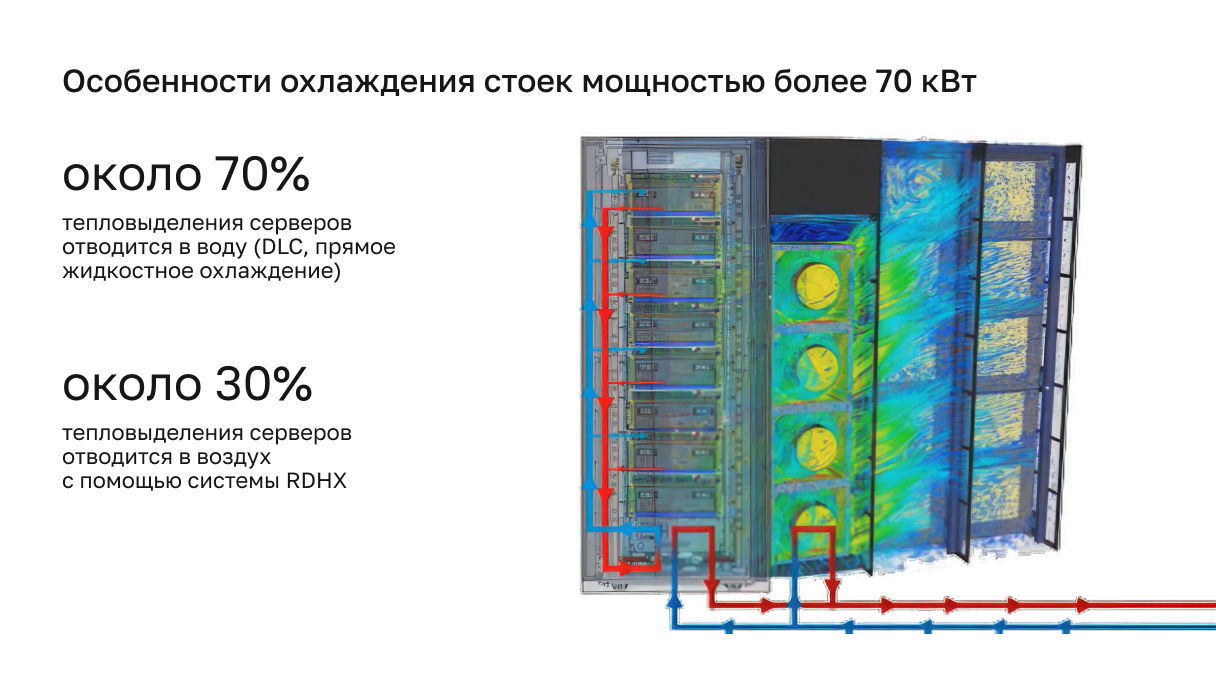

В пример специалисты приводят типичную стойку HGX: несколько серверов по восемь GPU NVIDIA H200 или B200 в каждом. Чтобы она работала стабильно, инженеры комбинируют прямое жидкостное охлаждение с RDHX. В среднем около 70% тепла уходит через cold plates, а оставшиеся 30% — в теплообменник двери. В сумме все 100% тепла улавливаются жидкостью и возвращаются в первичный контур ЦОДа.

Такой гибрид дает удобную отказоустойчивость, делает стойку менее чувствительной к изменениям нагрузки и упрощает масштабирование

Полное жидкостное охлаждение: опыт HPC

В HPC-суперкомпьютерах холодные пластины используются давно и для абсолютно всех внутренних компонентов. Они работают кластерами на 1 МВт мощности без единого вентилятора. Инженеры спокойно стоят рядом и разговаривают — настолько тихо работает система. Эта технология постепенно перестает быть эксклюзивом HPC, уже сейчас мы можем наблюдать её и в ИИ-кластерах среднего размера, когда требуется плотность выше 70–80 кВт в стойке.

Итоги

Жидкостное охлаждение не заменяет воздушное — оно дополняет его там, где современное оборудование выходит за рамки возможностей воздушных систем. На основе опыта ITGLOBAL.COM, лучше:

- до 10 кВт — использовать воздух;

- 10–20 кВт — усиленный воздух и начальные L2A-решения;

- 20–40 кВт — RDHX;

- 40–70 кВт — прямое жидкостное охлаждение;

- 100 кВт — гибрид DLC + RDHX или 100% жидкость.

Выбор типа охлаждения должен основываться на реальных нагрузках, прогнозе роста плотности стоек и экономической эффективности. Переход на жидкость позволяет не только справляться с высоким TDP чипов (свыше 500 Вт для CPU и 1000 Вт для GPU), но и снижать энергозатраты на 20–30% за счет повышения энергоэффективности, минимизации шума и оптимизации пространства ЦОД. Это особенно актуально в эпоху AI и HPC, где плотность вычислений растет экспоненциально, а правительства вводят строгие нормы по энергопотреблению (как в Европе с требованиями к теплым температурам в залах).

Внедрение DLC окупается в проектах с высокой плотностью. Например, в реализованных кейсах компании производительность кластеров выросла на 40–50% без глобальной перестройки инфраструктуры. Стандартизированные фитинги для гибридных систем минимизируют риски и обеспечивают совместимость оборудования от разных вендоров.