OpenAI решила буквально «похоронить» визуальный тест Тьюринга. Теперь вопрос «это генерация от ИИ или настоящее?» относится не только к фото, но и видеоматериалам. Нейросеть Sora способна повторять работы голливудских операторов: ее ролики отличаются абсолютной четкостью изображений, максимальной проработкой деталей и целым миром внутри каждого видео. Год назад это казалось фантастикой, а самые лучшие результаты показывала Gen-2 от Runway с ее мыльными картинками и минимальным движением камеры.

Но доступ к Sora дают только профессионалам в области создания визуального контента и специалистам по выявлению рисков и нежелательных поведений ИИ-инструментов. А пока ждем выход Sora в общий доступ, мы собрали бесплатные и доступные нейросети для генерации видеороликов и анимации изображений. При этом подчеркиваем, что перечисленные модели все еще далеки от создания полноценных роликов, которые было бы невозможно отличить от реального видео.

Gen-2 от Runway

Считалась самой мощной видеонейронкой до анонса Sora. Она генерирует довольно фотореалистичные ролики по 4 секунды (но можно увеличить время). Бесплатно дается 100 секунд, но всегда можно сделать новый аккаунт. Есть режимы image-to-video и text-to-video. Также модель научилась дорисовывать объекты для анимации, и введена опция Multi Motion, которая позволяет управлять несколькими областями при генерации видео. В Runway теперь можно анимировать на фото до 5 объектов.

Кстати, на базе Runway запустили телевидение. На сайте постоянно появляются новые нейроролики.

Еще один интересный факт: технологию Runway уже применили в кино. Команда разработчиков визуальных эффектов, создавшая фильм «Все везде и сразу», использовала модель для создания некоторых сцен.

Pika от Pika Labs

Генератор видео от Pika Labs вышел из бета-версии в открытый доступ. Если раньше можно было работать только в Discord, то сейчас генерируют видео прямо в браузере.

Нейросеть считается главным конкурентом Runway. Она тоже умеет делать ролики из текстового промта и изображения. Также можно модифицировать существующее видео, поменять его стиль. Из дополнительных функций: Pika умеет растягивать видео под разные форматы, дорисовывать объекты, менять одежду на людях. Pika Labs внедрили опцию encrypt, то есть зашифровка слова или изображения в ролике. Скрытый объект видно, если прищуриться. После обновлений разрешение видео теперь 1920х1080.

Moonvalley

Тоже работает в Discord, генерирует ролики на основе текстового запроса и картинки. В целом, хорошо понимает промт и не выдает ненужные артефакты. Можно выбирать стили: комикс, фэнтези, аниме, реализм, 3D анимация. Видео длительностью от 1 до 5 секунд.

Replay от Genmo

https://www.youtube.com/watch?v=UYy3toF2kcc

Genmo обновили свой генератор видео Replay и теперь он генерирует ролики на основе картинок, а не только понимает простые подсказки. Но самое главное, ИИ-инструмент создает фотореалистичные видео в HD-качестве (разрешение 2К). Также есть возможность выбирать соотношение сторон (16:9 и 9:16), расширенные настройки управления камерой, а длительность видео — до 10 секунд.

PromeAI

https://www.youtube.com/watch?v=ozY5fhT6g4M

Этот инструмент от LibAI Lab способен генерировать видеоролики, которые одновременно реалистичны и последовательны. Помимо поддержки генерации видео на основе текста, PromeAI также предлагает поддержку функций обработки изображений, таких как генерация текста в изображение, генерация изображения в изображение, замена фона, перерисовка, инпайтинг и другие популярные функции.

Invideo

Видеоредактор прямо в браузере. Сервис дает создавать по 10 минут каждую неделю, а остальное платно. В ролик можно добавить субтитры и редактировать зеленый экран, есть автоматическая обрезка под социальные сети и стабилизация.

Morph Studio

Работает в Discord и позволяет генерировать 7-секундные видео по текстовому запросу. В планах разработчиков создать свое онлайн-сообщетво, а пока нейросеть находится на ранней стадии.

NeverEnds

В начале декабря NeverEnds представила обновление в версии 2.0, в которой появилась функция генерации изображений в видео и поддержка мобильного опыта. В настоящее время NeverEnds предлагает два основных функционала: генерацию текста в видео и генерацию изображения в видео. В официальном описании подчеркиваются повышенная реалистичность и практичность, усиление изображения персонажей в ИИ-видео.

Stable Video Diffusion

https://www.youtube.com/watch?v=G7mihAy691g

Компания Stability AI, которая разработала ИИ для генерации изображений Stable Diffusion, выпустила Stable Video Diffusion, которая может создавать анимацию из текста и изображений. После обновления модель генерирует на скорости 25 к/с в разрешении 1024х576. Заметно лучше стала детализация видео, плавность движения камеры. Stable Video Diffusion неплохо имитирует природные явления, улавливает динамику кадра. Но ролики короткие, не хватает фотореализма и пока не получается генерировать людей на приемлемом уровне.

Stable Video 1.1 открыли для всех. Кроме того, код есть в репозитории на GitHub, а весовые коэффициенты, необходимые для локального запуска модели, можно найти на странице Hugging Face.

AnimateDiff

AnimateDiff добавляет новизны в анимацию изображений, сгенерированных в Stable Diffusion, Модель дает динамику, эффекты движения и виртуальные «полеты» с разных ракурсов, будто снято на камеру с дрона. AnimateDiff выдает короткие видео с разрешением 512×512.

VideoCrafter

https://www.youtube.com/watch?v=TUsFkW0tK-s

Работать можно в Discord, модель умеет Text2Video и Image2Video. После обновлений улучилась генерация картинки, а также обработка движений и композиции. Инструмент с открытым исходным кодом.

DynamiCrafter

Китайская компания Tencent, разработавшая мессенджер WeChat, представила модель DynamiCrafter для генерации видео. Первую версию показали в октябре, она выдавала разрешение 320 x 512, а сейчас 640 x 1024. Главная особенность — умеет реалистично поворачивать объекты на картинках.

Kandinsky Video от Sber AI

Это первая отечественная нейросеть для генерации видео. Kandinsky Video обучен на датасете из 300 000 пар «текст — видео». Выдает непрерывную сцену с движением как объекта, так и фона. Длительность роликов — до 8 секунд, частота кадров — 30 кадров в секунду, но пока это больше похоже на анимацию, а не полноценный ролик. Оценить Kandinsky Video можно на платформе fusionbrain.ai и в Telegram-боте.

Ждем релизы других видеогенераторов

Кроме того, несколько компаний тоже анонсировали свои генераторы видео, но доступа к ним пока нет:

- Lumiere от Google. Она создает реалистичные ролики по текстовому запросу, оживляет картинки, стилизует видео.

- Emu Video от Meta* AI. Модель обучена на 10 млн синтезированных образцов. Выдает разрешение 512×512 пикселей.

- Boximator от TikTok. Если у других нейросетей проблемой была непредсказуемость результатов, то эта способна контролировать изображения. Можно анимировать несколько объектов сразу.

- MagicVideo-V2 от TikTok. По мнению исследователей, это комплексная структура дает высокое разрешение, плавность и точность. Кроме того, платформа включает генерацию ключевых кадров и интерполяцию кадров.

Танцевальные видео

https://www.youtube.com/watch?v=8PCn5hLKNu4

Отдельное место занимают нейросети, которые помогают создавать персонализированные танцевальные видео с помощью изображений или текстовых подсказок:

- DreaMoving от Alibaba

- Animate Anyone от Alibaba

- MagicAnimate

Что дальше

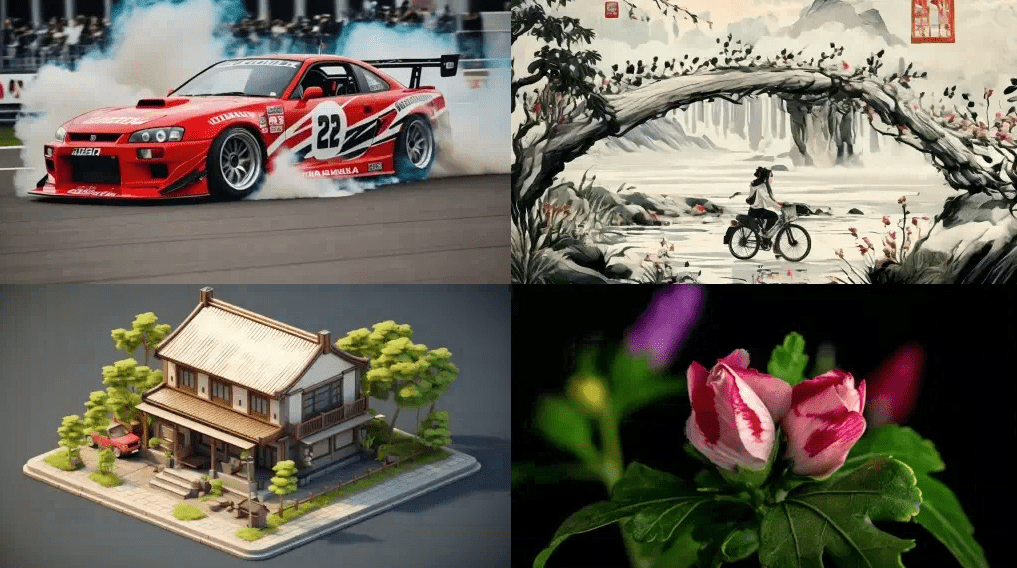

Помните, какой был прогресс в 2022-20023 году от Disco Diffusion до Midjourney и DALLE-3? А вот модели для генерации видео пока отстают. Видео сложнее делать, потому что нужно прорабатывать движение фона, персонажей, освещения, теней, фокусного расстояния, текстур. Создать картинку и создать ролик — разные задачи. Попробуйте описать движение лепестка двумя словами.

Но растет спрос на добавление динамики в статичные изображения. Пока мы в точке, где все генераторы видео и анимации выдают примерно одинаковое качество в плане работы с промтами. Но конкуренция — отличная штука.

Пока что делать минутные видео-новеллы с помощью нейросетей получается с трудом, качество явно уступает фильмам. С другой стороны, сгенерированные ролики отлично подходят как вставки для клипов, рекламы, соцсетей.

Meta* — экстремистская и запрещенная в РФ организация.