Apple выпустила семейство мини-моделей под названием OpenELM. Примечательно то, что модель сопровождается кодом для преобразования моделей в библиотеку MLX для вывода и точной настройки на устройствах Apple.

Компания Apple представила OpenELM — семейство языковых мини-моделей с открытым исходным кодом, которые способны функционировать на устройствах независимо от подключения к облачным серверам.

«Мы представляем OpenELM, семейство эффективных языковых моделей с открытым исходным кодом. OpenELM использует стратегию послойного масштабирования для эффективного распределения параметров на каждом уровне модели transformer, что обеспечивает повышенную точность».

О семействе OpenELM

В статье, описывающей семейство моделей, Apple заявляет, что разработкой OpenELM руководил Сачин Мехта при дополнительном участии Мохаммеда Растегари и Питера Затлоукала.

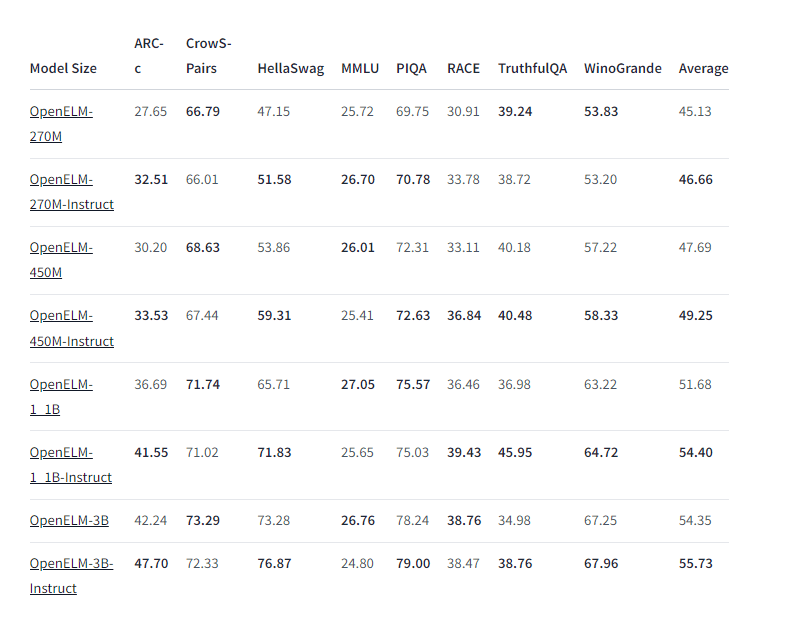

Семейство состоит из восьми мини-моделей, предназначенных для генерации текста. OpenELM имеют от 270 млн до 3 млрд параметров и были обучены на наборах данных из 1,8 трлн токенов, таких как Reddit, Википедия, arXiv.org и других.

OpenELM подходят для работы на обычных ноутбуках или смартфонах. Все модели в новом семействе используют уникальную стратегию послойного масштабирования для эффективного распределения параметров внутри каждого уровня модели transformer. По словам Apple, это позволяет им получать результаты повышенной точности при одновременной вычислительной эффективности.

Что касается производительности, результаты OpenLLM, опубликованные Apple на Hugging Face, показывают, что модели работают довольно хорошо, особенно вариант с инструкцией по 450 млн параметров.

В бенчмарке ARC-C, предназначенном для проверки знаний и навыков рассуждения, предварительно обученный вариант OpenELM-3B показал результат с точностью 42,24%. Между тем, на MMLU и HellaSwag он набрал 26,76% и 73,28% соответственно.

Зачем нужны мини-модели от Apple

Небольшие языковые модели не могут обладать всеобъемлющей базой знаний или разговорными возможностями, такими как у ChatGPT или Gemini, но они эффективны при решении конкретных задач и запросов и, как правило, менее подвержены ошибкам.

Несмотря на то, что Apple не упомянула какие-либо конкретные варианты использования моделей искусственного интеллекта, она предложила их весовые коэффициенты. Веса доступны по лицензии, которая разрешает использование кода как в исследовательских, так и в коммерческих целях.

Примечательно, что компания также приобрела французский стартап Datakalab, работающий с моделями компьютерного зрения.