Google и Apple представили новые функции для пользователей с ограниченными физическими возможностями. Project Gameface на Android и Eye Tracking на iOS позволяют управлять устройствами с помощью глаз или мимики лица.

![]()

В честь Международного дня осведомленности о доступности (Global Accessibility Awareness Day) Google и Apple объявили о внедрении новых функций, позволяющих пользователям управлять своими устройствами без использования рук.

Project Gameface на Android

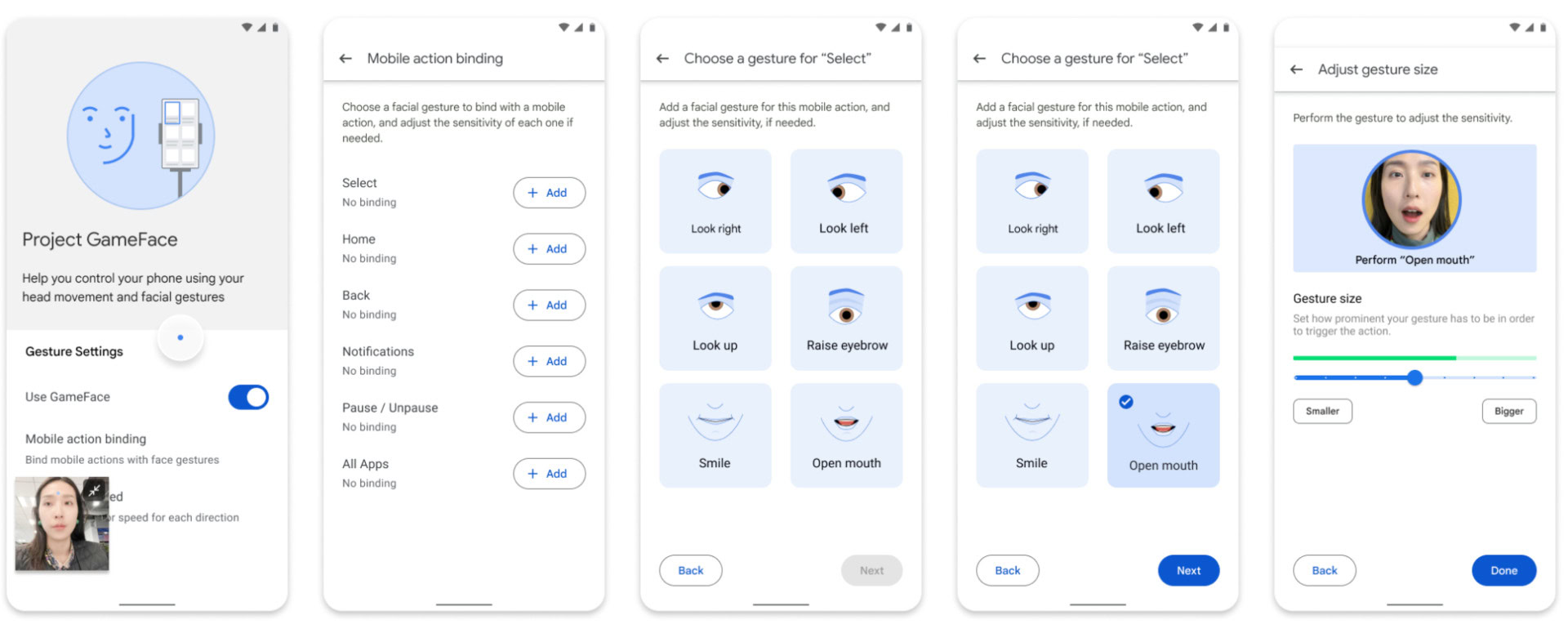

В своем блоге Google объявила о запуске функции Project Gameface для Android. Этот проект, впервые анонсированный в прошлом году для Windows, представляет собой систему, основанную на использовании движений головы и мимики лица для управления курсором компьютера и мобильными устройствами.

Project Gameface работает благодаря совокупности служб Android для специальных возможностей, платформы Google MediaPipe и фронтальной камеры устройства. Это позволяет пользователям управлять экраном и приложениями, поднимая брови и открывая рот.

Компания также предлагает настройку 52 положений и возможность менять размер жеста для активации определенных команд.

Однако Google отмечает, что разработчикам потребуется встроить поддержку Project Gameface в свои приложения.

Eye Tracking на iOS

С другой стороны, Apple представила Eye Tracking, функцию на основе искусственного интеллекта, которая предоставляет пользователям возможность управлять iPad и iPhone с помощью глаз.

Система Eye Tracking отслеживает движение глаз с помощью фронтальной камеры. Процесс настройки и калибровки занимает всего несколько секунд. Благодаря встроенному машинному обучению все данные, используемые для настройки и управления этой функцией, безопасно хранятся на устройстве и не передаются Apple.

:no_upscale():format(webp)/cdn.vox-cdn.com/uploads/chorus_asset/file/25449063/eyecontrol.gif)

Apple подчеркивает, что функция отслеживания глаз работает в приложениях iPadOS и iOS без необходимости дополнительного оборудования или аксессуаров. При использовании Eye Tracking пользователи могут перемещаться по элементам приложения и активировать любой из них с помощью функции Dwell Control, получая доступ к различным функциям, таким как физические кнопки, прокрутка и другие жесты.

Отмечается, что новая функция на основе ИИ была разработана Apple в сотрудничестве с OpenAI и Google.