Группа израильских исследователей из университета имени Бен-Гуриона провела эксперимент, который показал, что автопилот Tesla Model X не «видит» разницы между объемными объектами и их плоскими изображениями. Когда перед движущимся автомобилем на дорогу проецировалось изображение человека, система распознавания Tesla решала, что это настоящий пешеход. После чего, в зависимости от ситуации, автомобиль тормозил или поворачивал.

Фото: zdnet.сom

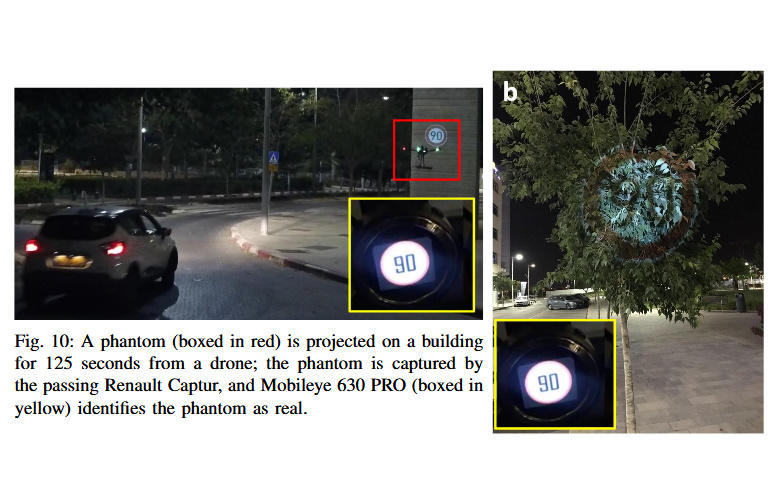

Кроме того, ученые использовали фантомные дорожные знаки. Они проецировались на деревья, стены домов и билборды — автопилот принимал их за настоящие. Еще Tesla ошибочно реагировала на фантомную разметку границы проезжей части, из-за чего могла повернуть в запрещенном месте.

Фото: zdnet.сom

Фото: zdnet.сom

Сценариев «обмана», как отметили исследователи, может быть множество. При этом для создания фантомных изображений можно использовать дешевые проекторы, устанавливая их в нужных местах или, например, прикрепляя к дронам.

Фото: zdnet.сom

Саму проекцию достаточно показывать меньше секунды, чтобы система распознавания среагировала на нее, а водитель даже не заметил. В лучшем случае машина может внезапно остановиться, в худшем — повернуть на встречную полосу.

В исследовании участвовала Tesla Model X, в которой, кроме автопилота, используется система активной безопасности Mobileye 630 PRO (такая же применяется в автомобилях Honda, Renault и Mazda). Исследовательская группа заявила, что уведомила Mobileye и Tesla о результатах эксперимента.

Некоторые современные системы распознавания лиц могут отличать лицо от его фотографии и предотвращать мошенничество с аутентификацией. То же самое, считают исследователи, должны уметь автомобильные системы.