При помощи алгоритмов инженеров Google четвероногий робот научился ходить всего за несколько часов — на 12 месяцев быстрее, чем среднестатистический человек.

Исследователи, связанные с Google Robotics, успешно запустили робота который способен самостоятельно обучаться, не полагаясь на симуляционные испытания. Участие человека в этом процессе сведено к минимуму. Процесс исследования описан в ознакомительном тексте, который команда выложила в сеть.

Используя глубокие методы обучения с подкреплением (англ. reinforcement learning) — тип машинного обучения, основанный на методе проб и ошибок, предоставляя при этом вознаграждение за определенные действия, — ученым удалось избежать программирования каждой команды, связанной с ходьбой, что позволило не прибегать к созданию симуляций.

Метод обучения с подкреплением обычно используется в виртуальной среде. Однако процесс построения симуляции, которая смогла бы воспроизвести движение робота по различным поверхностям — оказался сложным и времязатратным. Поэтому исследователи решили обучить свою систему в реальном мире.

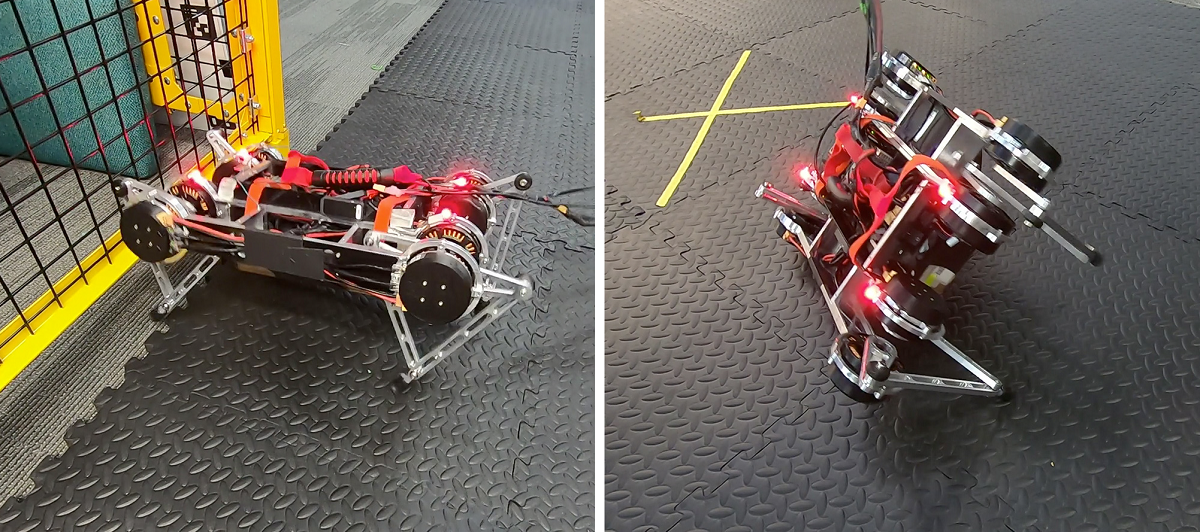

Для этого они позволили своему четвероногому роботу перемещаться по физической среде, прежде чем пустить его по разным территориям, таким как ровная поверхность, мягкий матрас и коврик с различными щелями. За считанные часы на каждой площадке он научился ходить вперед и назад и поворачивать влево и вправо. При этом ручное управление и перезапуск ни разу не понадобились.

Фото: arxiv.org

Разработчикам также пришлось снизить необходимость вмешательства человека в ситуациях, когда робот падал или пытался покинуть тренировочную зону. Для этого они заставили его выполнять несколько маневров одновременно и ограничивали его перемещение в пределах заданной границы. Когда он достигал края своей территории, он распознавал границу и шел обратно, а при падении мог самостоятельно подниматься.

То есть, единственное вмешательство людей в процесс, заключалось в том, что они добавили алгоритм, приказывающий роботу вставать после падения, но они надеются в конечном итоге автоматизировать и эту часть процесса обучения.

После того, как робот научился ходить, исследователи подключили игровой контроллер, который позволял им вручную перемещать робота, используя изученные им приемы для проверки результатов обучения.

В то время как область самообучения роботов передвижению все еще зарождается, это исследование предоставляет достаточные доказательства того, что это все-таки возможно. Исследователи полагают, что их система может помочь роботам обучаться ходьбе быстрее и эффективнее.