Грядущее доминирование Ethernet в высокопроизводительных сетях для ИИ становится все более реальным благодаря консорциуму UEC, что заставляет Nvidia защищать свои позиции на рынке, где безраздельно властвовал ее InfiniBand. В статье разберем отчет TrendForce, сравним задержки, стоимость, экосистему и то, как новый стандарт Ultra Ethernet 1.0 борется с главными преимуществами проприетарного решения Nvidia.

InfiniBand может уступить Ethernet свои позиции в ЦОД

Ethernet может вновь стать ключевым стандартом для масштабируемых дата-центров, в то время как InfiniBand продолжает удерживать лидирующие позиции в высокопроизводительных вычислениях. Компании Broadcom и Nvidia активно борются за доминирование на этом рынке — об этом сообщает международное агентство рыночной аналитики TrendForce.

В отчете агентства отмечается, что по мере роста моделей искусственного интеллекта развитие дата-центров сместилось от вертикального масштабирования к горизонтальному. Речь идет о переходе от отдельных высокопроизводительных систем к крупным кластерам, состоящим из десятков тысяч взаимосвязанных узлов. В таких архитектурах сеть становится критическим элементом, напрямую влияющим на масштабируемость и эффективность всей инфраструктуры.

Сейчас же на рынке сетей для горизонтального масштабирования активно используются две технологии:

- InfiniBand — высокопроизводительная технология, которую поддерживает Mellanox (дочерняя компания Nvidia). Она использует нативные протоколы RDMA, что позволяет достигать минимальной задержки в 2 микросекунды и исключает риск потери пакетов.

- Ethernet — семейство технологий пакетной передачи данных между устройствами для компьютерных и промышленных сетей. Благодаря своей открытой экосистеме и экономичности, эта технология активно продвигается такими крупными игроками, как Broadcom.

TrendForce указывает, что в июне 2025 года Ethernet сделал «решительный шаг вперед». Консорциум Ultra Ethernet Consortium (UEC) представил спецификацию UEC 1.0, которая существенно улучшила сетевой стек Ethernet и приблизила его характеристики к уровню InfiniBand. По мнению аналитиков, этот технологический сдвиг способен изменить баланс сил в сегменте масштабируемых дата-центров и постепенно увеличить долю Ethernet на рынке.

Чем сильна InfiniBand и почему она доминирует в ИИ-ЦОД

Архитектура InfiniBand для scale-out изначально поддерживает технологию удаленного доступа к памяти (RDMA). Принцип работы RDMA заключается в следующем:

- сетевой адаптер с поддержкой RDMA (RNIC) инициирует операции DMA для чтения или записи данных напрямую из памяти хоста, минуя участие CPU;

- RNIC инкапсулирует данные и передает их по сети напрямую на удаленный RNIC, который выполняет прямую запись или чтение в памяти принимающей системы без участия операционной системы.

В отличие от традиционных сетевых протоколов, таких как TCP/IP, этот процесс не требует участия CPU и сетевого стека ОС, что позволяет добиться чрезвычайно низкой задержки передачи данных — менее 2 микросекунд. Для задач распределенного обучения ИИ и высокопроизводительных вычислений это критически важно, поскольку задержки на уровне сети напрямую влияют на эффективность масштабирования.

Дополнительным преимуществом InfiniBand является встроенный механизм управления потоком на канальном уровне — Credit-Based Flow Control (CBFC). Он основан на системе кредитов, при которой отправитель может передавать данные только при наличии свободного буферного пространства у получателя. Такой подход предотвращает потерю пакетов на уровне сети и избавляет от необходимости использования сложных механизмов восстановления, характерных для Ethernet.

Для работы с нативным RDMA требуется специализированная инфраструктура InfiniBand, включая коммутаторы. На протяжении многих лет рынок таких решений фактически контролировала Nvidia через дочернюю компанию Mellanox. Это обеспечило InfiniBand высокую степень оптимизации и тесную интеграцию аппаратного и программного стека, но одновременно сделало экосистему закрытой и привело к росту стоимости оборудования и обслуживания. По оценкам аналитиков, коммутаторы InfiniBand обходятся примерно в три раза дороже, чем сопоставимые решения Ethernet.

Эволюция технологии InfiniBand // Источник: TrendForce

|

Год |

2011 | 2015 | 2017 | 2021 | 2024 | 2027 | 2030 |

|

Скорость передачи данных |

FDR (Fourteen Data Rate) | EDR (Enhanced Data Rate) | HDR (High Data Rate) | NDR (Next Data Rate) | XDR (eXtreme Data Rate) | GDR (E) | LDR (E) |

|

Пропускная способность / порт (8 линий) |

109 Гбит/с | 200 Гбит/с | 400 Гбит/с | 800 Гбит/с | 1.6 Тбит/с | 3.2 Тбит/с | 6.4 Тбит/с |

| Пропускная способность / порт (4 линии) | 54.5 Гбит/с | 100 Гбит/с | 200 Гбит/с | 400 Гбит/с | 800 Гбит/с | 1.6 Тбит/с |

3.2 Тбит/с |

| Пропускная способность / линия | 13.6 Гбит/с | 25 Гбит/с | 50 Гбит/с | 100 Гбит/с | 200 Гбит/с | 400 Гбит/с |

800 Гбит/с |

| Технология модуляции | NRZ | NRZ | NRZ | PAM4 | PAM4 | PAM6 (E) |

PAM6 (E) |

Примечание: (E) означает «Оценочное значение»

Эволюция технологии InfiniBand демонстрирует устойчивый рост пропускной способности. От поколений FDR и EDR технология перешла к HDR, NDR и XDR, а в перспективе — к GDR и LDR с использованием более сложных схем модуляции, таких как PAM4 и PAM6. Это позволило InfiniBand долгое время сохранять технологическое лидерство в сегменте высокопроизводительных сетей для ИИ-дата-центров.

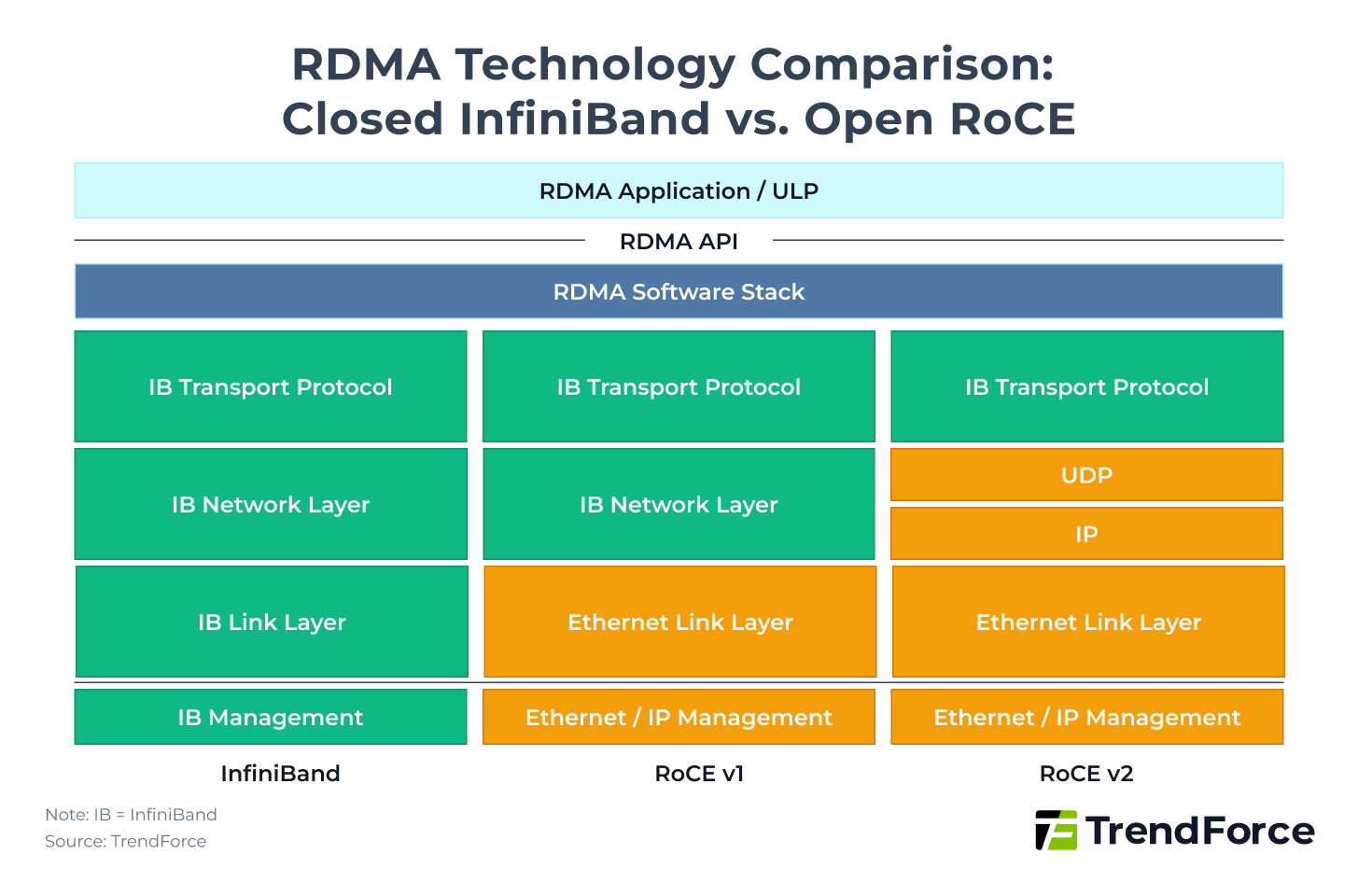

Как Ethernet пытался догнать InfiniBand через RDMA

Несмотря на доминирование InfiniBand в сегменте высокопроизводительных вычислений, Ethernet долгое время оставался основной сетевой технологией дата-центров благодаря своей открытой архитектуре, широкому выбору оборудования и более низкой стоимости. Попыткой приблизить Ethernet к возможностям InfiniBand стала технология RDMA over Converged Ethernet (RoCE), представленная ассоциацией InfiniBand Trade Association (IBTA) в 2010 году.

Первая версия технологии, RoCE v1, реализовывала RDMA поверх Ethernet на канальном уровне. Фактически она добавляла заголовок Ethernet к протоколу InfiniBand, что позволяло добиться низкой задержки, но существенно ограничивало область применения. RoCE v1 могла работать только в пределах одной подсети второго уровня и не поддерживала маршрутизацию через IP-сети, что делало ее малопригодной для крупных распределенных дата-центров.

Для повышения гибкости внедрения в 2014 году была представлена RoCE v2. В этой версии заголовок глобальной маршрутизации InfiniBand (GRH) был заменен на заголовок IP/UDP, что позволило Ethernet-коммутаторам и маршрутизаторам распознавать и передавать RoCE-пакеты. Благодаря этому RoCE v2 получила возможность работы через несколько подсетей и маршрутизаторов, значительно упростив интеграцию в существующую инфраструктуру дата-центров.

Однако за универсальность пришлось заплатить. Задержка в RoCE v2 остается выше, чем у нативного RDMA в InfiniBand, и составляет порядка 5 микросекунд. Кроме того, для минимизации потерь пакетов Ethernet-сети с RoCE требуют включения дополнительных механизмов управления трафиком, таких как приоритетная передача данных (Priority Flow Control, PFC) и явное уведомление о перегрузке (Explicit Congestion Notification, ECN). Эти механизмы усложняют настройку сети и повышают требования к качеству эксплуатации.

Таким образом, RoCE v2 позволил Ethernet приблизиться к InfiniBand по функциональности и масштабируемости, но не смог полностью устранить разрыв по задержкам и простоте работы без потерь. Именно эти ограничения долгое время оставляли InfiniBand предпочтительным выбором для ИИ-дата-центров, несмотря на более высокую стоимость и закрытую экосистему.

Ultra Ethernet Consortium и поворотный момент для Ethernet

Ситуация начала меняться в 2023 году, когда был создан консорциум Ultra Ethernet Consortium (UEC). В него вошли ключевые игроки рынка — AMD, Arista, Broadcom, Cisco, Eviden, HPE, Intel, Meta* и Microsoft. В отличие от экосистемы InfiniBand, где доминирует один вендор, UEC изначально сделал ставку на открытые стандарты и совместимость, чтобы снизить зависимость рынка от конкретного поставщика сетевых решений.

По данным TrendForce, именно деятельность UEC стала причиной того, что Ethernet в 2025 году сделал «решительный шаг вперед» в сегменте высокопроизводительных сетей для ИИ. В июне 2025 года консорциум представил первую официальную спецификацию UEC 1.0, которая не просто доработала существующий подход RoCE v2, а предложила комплексное переосмысление сетевого стека Ethernet.

Спецификация UEC 1.0 охватывает сразу несколько уровней архитектуры — программный, транспортный, сетевой, канальный и физический. Такой подход позволил устранить часть фундаментальных ограничений Ethernet, которые ранее мешали ему конкурировать с InfiniBand в задачах масштабируемого обучения ИИ.

Эволюция технологии Ethernet // Источник: TrendForce

|

Год |

2016 | 2018 | 2019 | 2021 | 2023 | 2025 | 2027 |

|

Общая пропускная способность на чип |

3.2 Тбит/с | 6.4 Тбит/с | 12.8 Тбит/с | 25.6 Тбит/с | 51.2 Тбит/с | 102.4 Тбит/с | 204.8 Тбит/с |

|

Количество портов на чип |

32 | 64 | 64 | 64 | 64 | 64 | 64 |

|

Пропускная способность / порт |

100 Гбит/с | 100 Гбит/с | 200 Гбит/с | 400 Гбит/с | 800 Гбит/с | 1.6 Тбит/с |

3.2 Тбит/с |

| Количество линий / порт | 4 | 4 | 4 | 4 | 8 | 8 |

8 |

| Пропускная способность / линия | 25 Гбит/с | 25 Гбит/с | 50 Гбит/с | 100 Гбит/с | 100 Гбит/с | 200 Гбит/с |

400 Гбит/с |

| Модуляция | NRZ | NRZ | NRZ | PAM4 | PAM4 | PAM4 |

PAM6 [E] |

Примечание: (E) означает «Оценочное значение»

Одним из ключевых элементов UEC 1.0 стала функция Packet Delivery Sublayer (PDS) на транспортном уровне. Она использует многоуровневую передачу данных (multipath), при которой между отправителем и получателем существует несколько равнозначных путей, или rails. Сетевая карта распределяет пакеты между этими путями на основе энтропийного значения, что позволяет передавать данные параллельно и эффективнее использовать доступную пропускную способность.

Такая архитектура повышает устойчивость сети: при возникновении проблем на одном из путей трафик может быть оперативно перераспределен, а потерянные пакеты — компенсированы без существенного влияния на задержки. По своей логике этот подход приближает Ethernet к принципам адаптивной маршрутизации, которые традиционно считались сильной стороной InfiniBand.

Для снижения риска потери пакетов в UEC 1.0 также предусмотрены два важных механизма. Первый — Link-Level Retry (LLR), позволяющий выполнять повторную передачу пакетов на канальном уровне, уменьшая зависимость от приоритетного управления потоком (PFC). Второй — опциональный механизм управления потоком на основе кредитов (CBFC), при котором отправитель может передавать данные только после получения подтверждения о наличии свободного буферного пространства у получателя. По своей логике он близок к CBFC в InfiniBand и позволяет приблизиться к работе без потерь.

За кем будущее и что выбирают компании

По оценке TrendForce, несмотря на заметный прогресс Ethernet, InfiniBand по-прежнему сохраняет ряд критических преимуществ. К ним относятся чрезвычайно низкая задержка передачи данных и архитектура, изначально рассчитанная на работу без потерь пакетов. Именно поэтому InfiniBand остается широко распространенным решением в современных ИИ-дата-центрах.

В то же время у этой технологии есть и очевидные ограничения. InfiniBand использует закрытую экосистему с ограниченным числом поставщиков, а стоимость оборудования и эксплуатации заметно выше, чем у Ethernet-решений. Эти факторы становятся все более чувствительными по мере роста масштабов дата-центров и увеличения числа узлов в кластерах.

Использование RoCE v2 поверх Ethernet не позволяет достичь той же минимальной задержки, что и у нативного RDMA в InfiniBand, однако оно предлагает открытую экосистему и значительно более низкие затраты на оборудование и обслуживание. Именно это, по мнению аналитиков, и подталкивает рынок к постепенному переходу на Ethernet-архитектуры в задачах масштабируемого обучения ИИ.

Сравнение ключевых параметров технологий выглядит следующим образом. InfiniBand обеспечивает задержку менее 2 микросекунд, тогда как для Ethernet с RoCE v2 этот показатель составляет менее 5 микросекунд. Текущая основная пропускная способность на порт у обеих технологий сопоставима и достигает 800 Гбит/с. При этом InfiniBand использует механизм Credit-Based Flow Control для работы без потерь, а Ethernet опирается на сочетание стандартных механизмов управления потоком 802.3x, PFC и ECN. Экосистема InfiniBand остается закрытой, тогда как Ethernet предлагает открытую модель с большим числом производителей. Стоимость оборудования InfiniBand, по оценкам TrendForce, примерно втрое выше, чем у сопоставимых Ethernet-решений.

Сравнение InfiniBand и Ethernet // Источник: TrendForce

|

Параметр |

InfiniBand (RDMA) | Ethernet (RoCE v2) |

|

Задержка |

< 2 мкс | < 5 мкс |

|

Текущая основная пропускная способность / порт |

800 Гбит/с | 800 Гбит/с |

| Механизм без потерь | Credit-Based Flow Control (CBFC) | Управление потоком Ethernet (802.3x), PFC, ECN |

| Экосистема | Закрытая (Nvidia) |

Открытая |

| Стоимость оборудования | Высокая (1x) |

Низкая (1/3) |

На фоне этих изменений Nvidia также начала корректировать свою стратегию. Компания больше не ограничивается исключительно развитием InfiniBand и активно выходит на рынок Ethernet. Помимо коммутаторов InfiniBand серии Quantum, Nvidia предлагает Ethernet-решения под брендом Spectrum.

В текущем поколении коммутатор Quantum-X800 поддерживает скорость 800 Гбит/с на порт и оснащен 144 портами, обеспечивая суммарную пропускную способность 115,2 Тбит/с. Модель Spectrum-X800, в свою очередь, также поддерживает 800 Гбит/с на порт, но имеет 64 порта и общую пропускную способность 51,2 Тбит/с. Совмещенные версии с оптической упаковкой (CPO) для Quantum-X800 и Spectrum-X800 запланированы к выпуску во втором полугодии 2025 и во втором полугодии 2026 года соответственно.

Несмотря на то что Ethernet-коммутаторы Nvidia остаются дороже решений конкурентов, компания получает преимущество за счет глубокой интеграции с собственным аппаратным и программным стеком. В сочетании с DPU BlueField-3 и платформой DOCA 2.0 это позволяет реализовать высокоэффективную адаптивную маршрутизацию и сохранить контроль над ключевыми элементами инфраструктуры ИИ-дата-центров.

Куда движется Ethernet и что это значит для рынка ЦОД

Параллельно с развитием спецификации UEC консорциум Ethernet Alliance представил обновленную дорожную карту развития Ethernet на ближайшие годы. В ней ключевой акцент сделан на поддержку рабочих нагрузок искусственного интеллекта, повышение пропускной способности и энергоэффективности сетей.

Согласно дорожной карте, Ethernet продолжит наращивать скорости передачи данных в масштабах ИИ-кластеров. Речь идет о межсоединениях 100G–800G и перспективных решениях со скоростью до 1,6 Тбит/с. Эти показатели должны обеспечить работу все более крупных распределенных систем обучения и инференса без резкого роста задержек.

Отдельное внимание уделяется развитию оптических технологий следующего поколения. В дорожной карте упоминаются решения с линейно-прямой оптикой (LPO), а также новые высокоэффективные медные и волоконно-оптические интерфейсы, позволяющие снизить энергопотребление и тепловыделение при росте пропускной способности.

Еще одним важным направлением остается оптимизация Ethernet для работы в дата-центрах и облачных средах. В частности, подчеркивается дальнейшее развитие Ethernet с поддержкой RDMA (Remote Direct Memory Access), позволяющей серверам обмениваться данными напрямую между оперативной памятью, минуя центральный процессор. Это направление логично дополняет инициативы UEC и сближает Ethernet с архитектурными принципами, которые долгое время были характерны исключительно для InfiniBand.

Помимо ЦОД и облаков, Ethernet Alliance указывает на расширение роли технологии в сегментах периферийных вычислений и Интернета вещей. Стандарты Ethernet будут адаптироваться для работы с маломощными устройствами и большим числом сенсоров, что расширяет область применения технологии за пределы классических дата-центров.

Вывод

InfiniBand по-прежнему остается эталоном для высокопроизводительных сетей в ИИ-дата-центрах благодаря минимальной задержке и архитектуре, изначально рассчитанной на работу без потерь пакетов. Однако его закрытая экосистема и высокая стоимость оборудования все чаще становятся сдерживающими факторами по мере роста масштабов инфраструктуры.

Ethernet, напротив, долгое время уступал InfiniBand по техническим характеристикам, но за счет открытой модели, большого числа поставщиков и активного развития стандартов постепенно сокращает этот разрыв. Появление Ultra Ethernet Consortium и спецификации UEC 1.0 стало поворотным моментом, показав, что Ethernet способен эволюционировать не точечно, а на уровне всей архитектуры.

На практике это означает, что в ближайшие годы рынок ИИ-дата-центров, скорее всего, придет не к замене одной технологии другой, а к сосуществованию двух подходов. InfiniBand сохранит позиции там, где критична минимальная задержка и максимальная эффективность, тогда как Ethernet будет все активнее использоваться в масштабируемых и экономически чувствительных сценариях. Монополия InfiniBand постепенно ослабевает, и конкуренция в сетях для ИИ-ЦОД вступает в новую фазу.

* Meta признана в России экстремистской организацией и запрещена