Насколько точно вы сможете отличить оригинальное видео политика или другой известной персоны от сгенерированного ролика, полностью имитирующего этого человека, вплоть до свойственных ему жестов, особенностей поведения и акцента?

Благодаря явлению, известному как иллюзорное превосходство, люди склонны считать себя лучше других. Поэтому, скорее всего, вы не думаете, что вас сможет одурачить компьютерная программа. Как никак, во время недавнего просмотра нового боевика о супер-героее вы запросто смогли назвать все созданные при помощи компьютерной графики сцены.

Однако не стоит забывать о том, что дипфейки (deepfake – серьезная подделка, цифровая фабрикация, замена лиц) являются настолько убедительными, что даже самые дотошные пользователи, применяющие соответствующие технологии, испытывают проблемы с нахождением отличий между реальным и сгенерированным компьютером видео. Это не просто дешевый трюк. В умелых руках дипфейки могут дестабилизировать целые общества, и стоит признать, что пока мы совсем не готовы бороться с этой угрозой.

Как работают дипфейки

Дипфейк представляет собой сфабрикованное видео, созданное с нуля либо основанное на уже существующих материалах, цель которого — воссоздать внешность и голос реального человека, выполняющего или говорящего вещи, которых на самом деле он никогда не делал. Как и многие другие инновационные технологии, дипфейки первоначально использовались в порнографии, когда в эротические ленты низкого качества вставлялись лица известных людей, с которых впоследствии требовался выкуп. Но время идет, технология развивается, и никто не может дать гарантии, что в ближайшем будущем в дипфейках мы не увидим действующего президента или другую политическую фигуру, говорящих и делающих то, что хочет нам сообщить их автор.

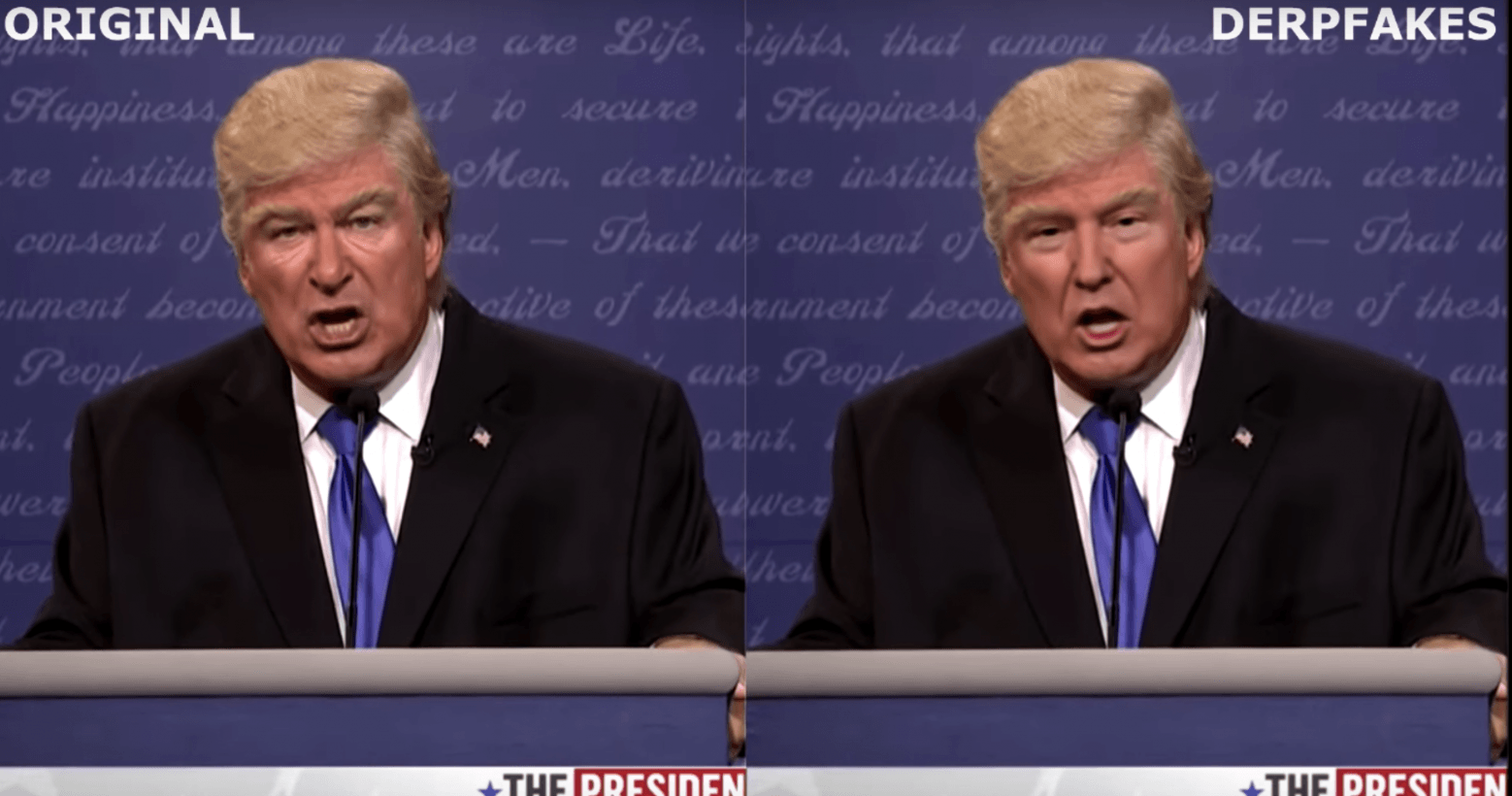

Почему дипфейковые видео гораздо убедительнее продуктов, созданных с использованием Photoshop? Дело в том, что в процессе их создания используются генеративно-состязательные сети (GAN). Эти сети управляются очень умными алгоритмами искусственного интеллекта, основанными на комбинации двух нейронных сетей: одна пытается создать как можно более убедительное видео (поддельщик), а другая пытается отличить подлинные образцы от неправильных (сыщик). Объединяя данные этих двух источников и постепенно создавая новые циклы видео, можно получить очень реалистичные видеофайлы.

Если это кажется вам не убедительным, посмотрите на сфабрикованное видео бывшего президента Соединенных Штатов, Барака Обамы, созданное специально для того, чтобы продемонстрировать возможности технологии. Учитывая, что видео уже более года, стоит задуматься о том, насколько умнее стала технологии за это время.

Почему мы не готовы

Возможно, говорить о том, что мы не готовы к последствиям, связанным с влиянием новой технологии, кому-то покажется слишком преувеличенным, тем не менее, не стоит забывать о нескольких важных моментах.

Во-первых, на нас уже не раз испытывали силу фейковых новостей. Так, определить реальное влияние сфабрикованных статей во время президентских выборов 2016 года в США сложно, тем не менее, даже небольшой эффект от таких новостей способен изменить судьбу целой страны, и многие считают, что президент Трамп выиграл именно таким образом.

В данном случае дипфейки представляют собой сфабрикованные новостные статьи, выведенные на новый уровень убедительности. Одно дело подозревать, что статья была написана с корыстной целью или ставить под сомнение факты, представленные в одной статье в интернете. И совсем другое – видеть, как известный политик рассказывает о чем-либо лично. Обнаружить дипфейки чрезвычайно сложно, ведь, как мы помним, процесс их разработки включает в себя алгоритм «сыщика». Убедить людей, что их обманывают, непросто. Миллионы людей, читающих новости в интернете, даже не подозревают о существовании дипфейков.

Добавим к этому то, что со временем само создание дипфейков становится дешевле и проще, а их обнаружение – сложнее. Возможности технологии развиваются со стремительной скоростью, и не за горами то время, когда дипфейковые видео смогут создавать самые обычные интернет-пользователи.

Попробуем абстрагироваться от всех этих проблем и допустить, что у нас имеются способы обнаружения дипфейков. Но каким образом можно контролировать последствия от демонстративно сфабрикованных видео, распространяемых в соцсетях? Даже если нам заранее известно о том, что видео поддельное, его просмотр может повлиять на наше восприятие того или иного человека, а социальные сети не особо утруждаются, чтобы контролировать такого рода контент. Это стало очевидным во время недавнего инцидента со спикером Палаты представителей США Ненси Пелоси, фейковое видео с участием которой в якобы пьяном виде было оставлено в Facebook, несмотря на негодование общественности. Представитель Facebook Моника Бикерт (Monika Bickert) прокомментировала ситуацию следующим образом: «Мы считаем, что людям важно делать собственный информированный выбор, чему они должны верить». В этом отношении сфабрикованная или недостоверная информация не нарушает правил Facebook или других крупных платформ соцсетей.

Что можно сделать?

Любому знакомому с проблемой дипфейков человеку ясно, что в перспективе они способны дестабилизировать и даже разрушить наш мир, причем на данный момент способа противостоять проблеме не существует. Однако от того, что мы это признаем, ситуация не изменится – необходимо искать решение. Что можно сделать, чтобы подготовиться (или уменьшить) к угрозе, которую несут в себе дипфейки?

Чтобы быть готовыми к приближающемуся наплыву фейковых видео, необходимо действовать в трех направлениях. Во-первых, нужно рассказать людям о том, что дипфейки существуют, следовательно, даже к самым, казалось бы, реалистичным видео необходимо относиться с долей скептицизма. Во-вторых, следует разрабатывать технологию, способную определять алгоритмически сгенерированные видеоматериалы – препятствие, которое кажется необыкновенно сложным, учитывая способ работы GAN, но все-таки это возможно. В-третьих, нужно установить дополнительные требования к платформам соцсетей, ведь именно здесь дипфейки имеют самое большое влияние. Фраза о том, что размещение дипфеков «не нарушает условий предоставления услуг» не должна считаться простительной. Чтобы контролировать такой вид контента, необходимы другие функции, и вводить их нужно как можно скорее.