В 2011 году мы рассказывали про автоматическую систему, которая научилась предсказывать время и место правонарушений. Программа была основана на принципах предсказания «афтершоков», то есть повторных толчков после основного землетрясения. По словам авторов алгоритма, преступления следуют по тому же принципу: за одной кражей неизбежно произойдет и вторая.

При ретроспективной прогонке система успешно предсказала до 25% преступлений в Лос-Анджелесе. 11 лет назад это был хороший процент, однако сегодня исследователи создают алгоритмы, которые могут определить вероятность с точностью до 90%.

Подобную программу разработали аналитики данных и социологи из Чикагского университета. Алгоритм делит город на одинаковые квадраты, анализирует время и место отдельных преступлений на основе общедоступных данных, а затем прогнозирует будущие события.

Казалось бы, идеальный алгоритм для обеспечения безопасности на улицах. Однако сами ученые признают, что его не следует применять для защиты правопорядка. Все потому, что если увеличить число полицейских в тех районах города, где ожидается преступление, это приведет к изменению условий и снизит точность предсказания. Система, скорее, может показать будущую картину правонарушений на территории.

Алгоритм ученых из Чикаго является place-based системой или программой, ориентированной на место совершения правонарушения. Также существуют person-based машины, которые определяют потенциального нарушителя. Мы изучили оба этих подхода.

Подозрительные списки искусственного интеллекта

В 2021 году издание The Verge рассказало историю Роберта МакДэниела, которого алгоритм посчитал опасным. Система показала, что вероятность его участия в перестрелке выше, чем у 99,9% населения города. Роберт оказался под наблюдением, и в конце концов на него совершила покушение одна из местных банд.

Преступники подумали, что раз рядом с молодым человеком постоянно находятся полицейские, он работает вместе с ними. Предиктивный алгоритм оказался прав – Роберт действительно стал участником перестрелки, однако человеку он не помог.

Person-based системы определяют, кто и с какой вероятностью станет жертвой или совершит преступление. Они оценивают возраст, криминальную историю, данные о трудоустройстве и делают свой прогноз. Это может быть и предсказание рецидивов, и выявление связей в криминальном мире, и даже определение размера наказания для осужденных. При этом разработчики часто скрывают набор показателей и метод работы алгоритмов.

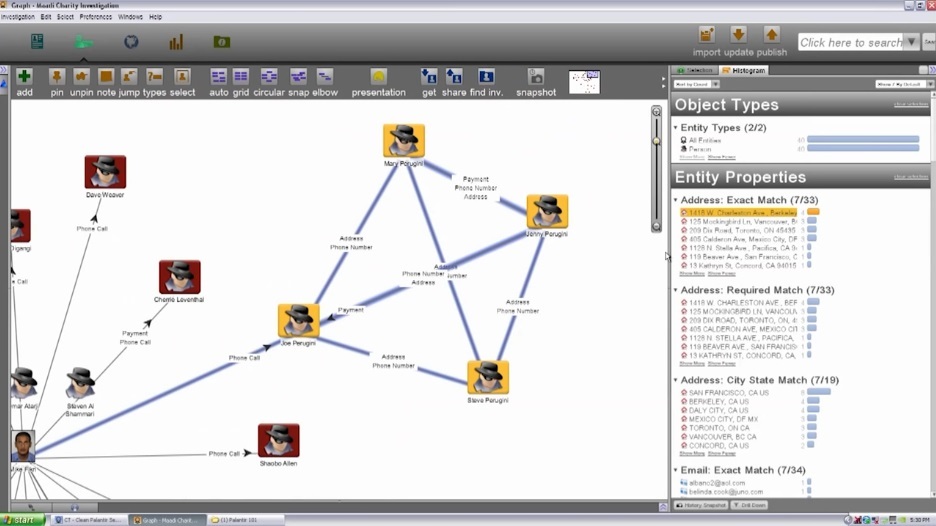

Иногда скрывается даже факт их применения. Например, использование алгоритма Palantir полицией из Нового Орлеана было обнаружено только через шесть лет с момента запуска. До этого программа никогда предсказывала преступления в гражданской среде.

Palantir – изначально, аналитический инструмент для спецслужб. Он комбинирует информацию из множества источников и преобразуют ее в сложную структуру, которая отражает скрытые и явные связи между объектами. Эту программу придумал Питер Тиль, а вдохновил его не только «Властелин колец», но и алгоритм против мошенников под названием Igor.

«Игорь» бил тревогу всякий раз, когда пользователь PayPal вел себя необычно. Например, регулярно снимал со счета максимальную сумму. Алгоритм очень помог платежной системе в начале 2000-х, когда она столкнулась с волной мошенничества.

Palantir поддержал и полицию Нового Орлеана. Местным аналитикам был предоставлен доступ к судебным выпискам, адресам телефонов и сведениям из социальных сетей жителей города. С помощью этих данных программа подготовила карты взаимодействия, по которым можно было определить связи людей, автомобилей, оружия и даже постов на Facebook. Полицейским достаточно было просто ввести псевдоним преступника, и система выводила весь комплекс его контактов.

В первые два года число преступлений в Новом Орлеане действительно снизилось, и почти на треть. Однако потом результат программы перестал быть статистически значимым. В итоге эксперты признали, что снижение количества правонарушений не связано с системой.

Person-based алгоритмы разрабатываются не только в США. Китай также использует системы распознавания лиц и предиктивные инструменты. Технологии идентификации сочетаются с огромной биометрической базой жителей Поднебесной. В 2019 году она включала информацию практически о каждом из 1,4 миллиарда граждан страны. Дело в том, что большинство официальных документов в Китае, например, паспорт и водительские права нельзя получить без передачи биометрии.

Все эти данные используют алгоритмы, наблюдающие за гражданами через камеры на улицах Китая. Например, программа Dragonfly Eye System, которая умеет определять людей на видео с точностью до 95%. В основе системы лежит облачная база из 1,7 миллиардов цифровых портретов, а также технология распознавания лиц по набору ключевых зон и параметров, например, по форме овала лица, высоте лба и структуре носогубных складок.

Каждому из признаков присваивается рейтинг в соответствии с их уникальностью: человек может перекрасить волосы или отрастить бороду, а вот изменить форму ушей намного сложнее. Идентификация считается успешной, если совпадение преодолевает пороговое значение рейтинговых баллов.

Компания-разработчик Yitu показала свою систему в собственном офисе. Как только человек входит в здание, программа моментально делает серию снимков, выбирает из них самую качественную фотографию и определяет область лица. Затем алгоритм преобразует картинку в облако точек, которое сравнивается с данными из базы. Алгоритму требуется всего около секунды, чтобы узнать человека.

Последний компонент «идеальной» предиктивной системы в Китае – нейросеть для оценки риска совершения преступления. Как раз такой алгоритм разрабатывает компания Cloud Walk. Система отслеживает действия человека и присваивает ему определенный рейтинг «подозрительности».

«Если кто-то купит кухонный нож, система не увидит в этом злого умысла. Однако если этот же человек следом приобретет молоток и мешок, алгоритм внесет его в список подозрительных лиц» – рассказал Financial Times один из разработчиков.

Программа используется уже в 30 городах Китая, однако про ее эффективность на данный момент ничего не известно. Мировое сообщество с большим подозрением относится к этим технологиям Поднебесной. Например, Софи Ричардсон, руководительница китайского отделения международной организации Human Rights Watch, назвала Dragonfly Eye System инструментом, предназначенным в первую очередь для «нарушения конфиденциальности и борьбы с инакомыслием».

В Европе также разрабатываются и тестируются person-based системы предсказания преступлений. В Великобритании, например, полиция могла бы получить в помощники программу Most Serious Violence (MSV). Предполагалось, что алгоритм будет вычислять вероятных преступников по 20 ключевым критериям. За два года проект получил от государства почти 966 миллионов в переводе на рубли, и во время экспериментального запуска показал точность до 75%.

Однако на практике специалисты не смогли установить момент, когда полицейские должны вмешаться, чтобы предупредить преступление. В результате система оказалась бесполезной. Разработчики попытались ее исправить, но после корректировки ее точность упала до 9-19%. Конечно, комитет по этике единогласно отклонил проект.

Этичность использования person-based инструментов в целом вызывает много вопросов. В частности, Европарламент считает внесение человека в список подозрительных лиц дискриминацией на пустом месте и выступает за запрет предиктивной полиции на основе ИИ по отношению к личности. Однако, в документе нет запрета на предсказания преступлений с помощью place-based алгоритмов.

Место преступления и сейсмология

Place-based системы более универсальны. Обычно разработчики таких алгоритмов основываются на теории «разбитых окон», а также законах сейсмологии. Основная задача полиции, которая использует такие предиктивные программы – контроль «горячих» зон с высокой интенсивностью преступлений.

[cut]

Теорию «разбитых окон» сформулировали американские ученые Джеймс Уилсон и Джордж Келлинг. По их мнению, если в здании разбито одно окно и никто его не заменяет, то через определенное время в доме не останется ни одного целого стекла. Другими словами, равнодушие к мелким преступлениям одного человека мотивирует и других совершать правонарушения.

[/cut]

Самой известной place-based системой является программа PredPol. В ее основу как раз и заложили принципы сейсмической активности после землетрясений. Ее предварительно обучили, а затем «скормили» алгоритму данные о преступлениях за последние 10 лет. На их основе PredPol стала подсвечивать места на карте, где вероятность инцидентов казалась ей высока. Интерфейс стали использовать в 60 полицейских участках США.

Казалось бы, эта система лишена недостатков person-based алгоритмов: она никого персонально не дискриминирует, данные без спроса не использует и при этом помогает обеспечивать безопасность в неспокойных районах. Более того, исследователи провели эксперимент и выяснили, что благодаря place-based системам частота некоторых преступлений в Лос-Анджелесе и городе Кент в Великобритании снизилась на 7,4%.

Однако объективный алгоритм «перенимает» людские пороки. Во-первых, из-за непрозрачности программы проверить ее практическую эффективность очень сложно. Это может сыграть на руку недобросовестным стражам закона: им будет очень легко манипулировать данными. Например, недавно полиция Мемфиса отчиталась, что система помогла сократить преступность.

Позже обнаружилось, что полицейские сравнивают данные с годом установки системы, в который произошел неожиданный всплеск правонарушений. После перепроверки оказалось, что реальная статистика намного сложнее. Хотя общее число правонарушений действительно снизилось на 8%, это напрямую не связано с программой. Более того, в городе на 14% возросло количество насильственных действий.

Во-вторых, PredPol и другие системы обучаются на отчетах, которые вносят сами полицейские. И если люди предвзято составляли протоколы, то и машина будет оценивать территорию на основе искаженной информации. Еще один аргумент критиков также связан с субъективным человеческим взглядом. Если стражи закона ожидают нарушения правопорядка в каком-либо районе, скорее всего, они будут стараться найти преступника вне зависимости от обстоятельств. В результате точность предсказаний оказывается под вопросом.

Несмотря на все недостатки, разработчики не оставляют попыток создать идеальную предиктивную систему для использования на практике. Однако пока что все упирается в две крайности: этический вопрос обвинения личности и точность предсказаний. Поэтому пока что приговора за намерение от искусственного интеллекта, скорее, можно не опасаться.